Beim Stichwort Weltmarktführer fallen einem sofort Unternehmen wie Amazon, Google oder Apple ein. Sie sind überaus erfolgreich und fast jedem bekannt. Doch es gibt auch umsatzstarke Firmen, die kaum jemand kennt. Sie werden Hidden Champions genannt. Deutschland hat jede Menge davon.

Trends & Zukunft

Process Mining – Datengetriebene Prozessanalyse

Effiziente Abläufe, Prozesstransparenz und Risikoerkennung sind der Schlüsselfaktor für eine erfolgreiche Organisation. Nicht ohne Grund beschäftigen größere Unternehmen eigene Abteilungen mit dem Auftrag zur Prozessoptimierung und der Revision. Die komplette Prozesskette – z. B. im Einkauf von der Bedarfsentstehung bis zur Zahlung – ist auf operativer und strategischer Arbeitsebene regelmäßig zu hinterfragen. Infolge der erhöhten Unterstützung der Prozessverarbeitung durch ERP– und andere IT-Systeme sowie der steigenden Abhängigkeiten inner- und außerbetrieblicher Prozesse, nimmt der Aufwand für das Monitoring von Geschäftsprozessen rasant zu.

Infografik zur Industrie 4.0

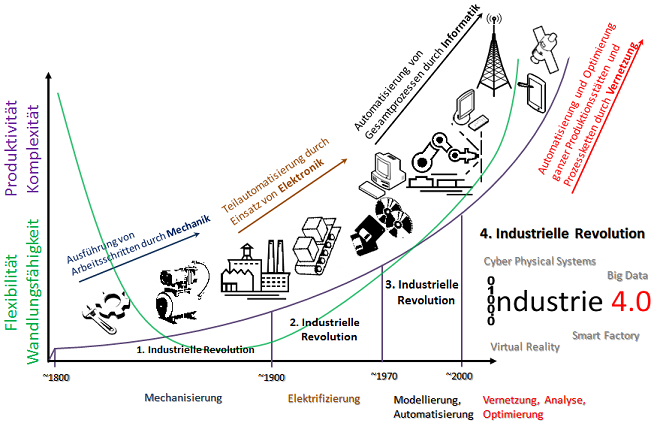

Industrie 4.0: Von der Dampfmaschine zur Smart Factory

Die Industrie 4.0 hat in moderne Werkshallen Einzug gehalten. Die IT verschmilzt zunehmend mit Fabriken, Produktionsanlagen und Logistikprozessen. Aufgrund des massiven Bedeutungszuwachses der intelligenten Fabrik (Smart Factory) für den deutschsprachigen Raum hat die tarakos GmbH eine Infografik erstellt, um den Weg von mit Wasser und Dampf betriebenen Produktionsanlagen hin zu zur vierten industriellen Revolution aufzuzeigen.

Während die Internet-Gemeinschaft noch über das sogenannte Web 3.0 diskutieren, versucht die Industrie inzwischen in der Version Nr. 4 anzukommen. Gemeint sind damit neben der fortschreitenden industriellen Entwicklung, auch die Veränderungen und Schwierigkeiten der Produktions- und Arbeitswelt. Die Globalisierung stellt in diesem Zusammenhang die Industrie vor neue Herausforderungen.

Die Infografik finden Sie weiter unten in diesem Artikel!Energiemanagment in der Industrie 4.0

Sogenannte M2M-Lösungen (Machine to Machine) erhalten in dem sekundären Wirtschaftssektor unter dem Oberbegriff Industrie 4.0 eine immer wichtigere Bedeutung, da neue Potenziale für Unternehmen freigesetzt werden, die noch vor wenigen Jahren verborgen geblieben waren. Dabei steht M2M in erster Linie für einen automatisierten Informationsaustausch zwischen mindestens zwei Maschinen. Dieser kann beispielsweise zwischen Endgeräten, Produktionsmaschinen, Automaten, Kraftfahrzeugen oder mit einer zentralen Leitstelle erfolgen. Wird das Internet als Verbindungselement zwischen den Maschinen bzw. Endgeräten genutzt, wird auch vom Internet der Dinge (Internet of Things) gesprochen. Während lokale M2M-Lösungen z. B. mit RFID arbeiten, werden beim Internet der Dinge verschiedenen WAN-Zugangsnetze als Kommunikationsweg genutzt. M2M-Lösungen verknüpfen somit die Informations- mit der Kommunikationstechnik.

Energieeffiziente Gestaltung der Prozesse

Mithilfe derartiger Lösungen können Arbeitsabläufe kostengünstig rationalisiert und Produktivitätssteigerungen erreicht werden. Sobald zum Beispiel Verkaufsautomaten mit einem Zentralcomputer verbunden werden, können sie diesem selbständig mitteilen, welche Behälter um wie viel Bestand befüllt werden müssen. Eine solche kontinuierliche Fernüberwachung der Verkaufsautomaten beugt längeren Ausfallzeiten vor und verhindert, dass der Automatenbetreiber eine direkte und regelmäßige Kontrolle an dem Automaten vornehmen muss. Die entstehende Rationalisierung der Geschäftsprozesse und die damit verbundenen Kosteneinsparungen weisen für die Industrie ein immenses Marktpotenzial auf.

Energiemanagement und M2M

Vor allem im Energiemanagement spielt M2M heute eine ungemein wichtige Rolle. Da die Nachfrage an Energie kontinuierlich zunimmt, steigen die Energiekosten für die Verbraucher als auch für die Industrie. Gleichzeitig ist ein großer Energieverbrauch mit einer einhergehenden Umweltbelastung verbunden, weshalb die Kostensenkung und Nachhaltigkeit durch die Benennung und Aufklärung des Energieverbrauchs sämtlicher Verbraucher optimiert werden kann. Dies kann durch sogenannte Energy-Konzepte erreicht werden. Ein solches Energy-Konzept ist zum Beispiel Smart Monitor, Smart Mobile und Smart Complete. Vor allem die letztere Energy-Methode bedient sich der M2M-Technologie und ist für intelligente Stromnetze, sogenannte Smart Grids, bekannt. Das Smart Complete-Energy-Konzept ist ein Komplettsystem der Stromablesung, dass intelligente Stromnetze automatisiert. Intelligente Stromnetze beinhalten Stromzähler, welche den tatsächlichen Energieverbrauch in Echtzeit anzeigen und ihn automatisch an den Energieversorger und den Verbraucher übermitteln. Weiterhin ermöglichen intelligente Stromnetze (über ein benutzerfreundliches Kundenportal individuelle Informationen für energiebewusstes sowie -effizientes Wohnen. So soll gewährleistet werden, dass Smart Complete bei maximaler Effizienz ein Höchstmaß an Transparenz aufweist. Große Telekommunikationsunternehmen wie Telefónica setzen in Zeiten der Industrie 4.0 bereits auf Smart Meter Konzeptlösungen (Klick für Infos!).

Für Unternehmen ist ein Smart Complete-System besonders vorteilhaft, da es eine ganzheitliche Smart Metering-Lösung für den Energievorsorgemarkt darstellt, die Verarbeitung von Daten sämtlicher Energiearten ermöglicht, einen Keep Alive-Service für eine automatische Gatewaykontrolle inklusive einer Alarmfunktion beinhaltet und viele weitere Vorteile umfasst, die den Rationalisierungsprozess hinsichtlich des Energiebedarfs in einem Unternehmen begünstigen.

Big Data Analytics mit Hadoop – Buchempfehlung

Big Data ist eines der Buzzwords dieser Jahre und steht für das Potenzial der heranwachsenden Datenmengen für Wirtschaft und Wissenschaft. Das Potenzial ergibt sich aus dem Erfassen und Sammeln dieser Datenmengen aus den unterschiedlichsten Quellen. Die Nutzung des Potenzials erfolgt jedoch erst mit der Datenanalyse, daher wird oftmals zwar von Big Data geredet, jedoch Big Data Analytics gemeint.

Das in der Praxis am häufigsten vorkommende Datenbankmodell ist die relationale Datenbank, die Daten in untereinander verknüpfte Tabellenstrukturen speichert. Relationale Datenbanken sind zwar nicht direkt auf eine bestimmte Größe beschränkt, so begrenzt ausschließlich das Betriebssystem die Größe einer MySQL-Datenbank, dennoch tauchen bei großen Abfragen mit SQL-Queries oftmals schwer nachvollziehbare Fehler auf. Eine fehlgeschlagene SQL-Query lässt sich nur schwer debuggen, wenn sie nach Stunden abbricht.

Abhilfe verspricht Apache Hadoop mit einem verteilten Dateisystem (HDFS) und dem NoSQL-Ansatz und MapReduce-Algorithmus, der auch die Analyse von unstrukturierten Daten ermöglicht. Durch HDFS werden mit Commodity Hardware Datensammlungen und Analysen im Petabyte-Bereich möglich. Für die Auswertung der Datenmengen werden dadurch auch keine backup-kritischen Großrechner mehr benötigt, denn MapReduce-Jobs können auf verschiedener, räumlich getrennter Hardware zeitlich parallel erfolgen, erst die Ergebnisse werden auf einem dafür vorbestimmten Rechner (Server) zusammengetragen und weiterverarbeitet. Dabei werden Daten über die verteilte Hardware redundant gehalten, was als Data Warehouse (unter bestimmten Voraussetzungen) Ausfallsicherheit bedeutet.

Hadoop ist ein freies Open Source Framework, dessen Entwicklung von der Apache Software Foundation vorangetrieben wurde. Es wird auch von den Unternehmen eingesetzt, die heute als Pioniere von Big Data gelten, beispielsweise Facebook, Yahoo!, Twitter, Amazon und Google. Vor allem Google, Facebook und Yahoo! steuerten große Teile zu Hadoop bei.

Hadoop: Zuverlässige, verteilte und skalierbare Big-Data-Anwendungen

Das Buch Hadoop – Zuverlässige, verteilte und skalierbare Big-Data-Anwendungen vom Autor Ramon Wartala bietet einen breiten und tiefen Einblick in Hadoop und dessen modulare Nebensysteme:

- Datenfluss-Sprachen:

- Hive

- Pig

- CludBase

- Spaltenorientierte Datenbanken

- HBase

- Hypertable

- Daten-Serialisierung

- Avro

- Thrift

- Google Protocol Buffer

- Sqoop

- Workflow-Systeme

- Azkaban

- Oozie

- Cascading

- Hue

- ZooKeeper

- Mahout

- Whirr

Das Buch führt ausführlich durch die Installation von Hadoop auf einem Linux-System, leitet die ersten Schritte im Umgang mit dem verteilten Dateisystem von Hadoop (HDFS) sowie zur Implementierung von MapReduce-Algorithmen an. Auch in die empfohlene Entwicklungsumgebung Eclipse (mit Plugin) wird hinreichend eingewiesen. Zum Ende gibt der Autor noch Tipps rund um das Management und die Überwachung der MapReduce-Jobs und des Hadoop-Ökosystems. Ferner werden vier Beispiele des Hadoop-Einsatzes in der Praxis vorgestellt. Wer einen Einstieg in die Praxis von Hadoop finden möchte, kann sich Hadoop als Standalone-Anwendung installieren und die Datenverteilung simulieren, oder sich Linux-Server bei Providern anmieten.

Hadoop besteht im Wesentlichen aus Java Programmcode (von Oracle, vormals Sun Microsystems), daher ist zumindest ein Grundwissen in Java notwendig, um tiefer in Hadoop eintauchen zu können und auch um die Quellcode-Beispiele im Buch verstehen zu können. Außerdem sind Linux-Kenntnisse (insbesondere Ubuntu/Debian) vorteilhaft. Wer kein Freund der Programmiersprache Java ist, kann durch das Hadoop Streaming auch MapReduce-Funktionen in C, Ruby, PHP oder Python realisieren; Hierfür bietet Hadoop eine Standardein/ausgabe-Schnittstelle an.

Industrie 4.0 – Konzepte und Herausforderungen

Das Zukunftsprojekt Industrie 4.0 wird unsere Industrie verändern. Produktions- und Lieferzeiten werden durch intelligente Steuerung verkürzt und hinsichtlich des Ressourceneinsatzes optimiert werden. Die virtuelle Realität wird Produkte von noch besserer Qualität schaffen, bei kostengünstigerer Produktentwicklung, die näher an die Fertigungsprozesse rücken wird. Durch das Internet der Dinge wird die Produktion und Logistik zuverlässiger sowie für Kunden transparenter werden. Insgesamt wird die Industrie 4.0 anders als die vorangegangenen Industrierevolutionen nicht nur insgesamt die Produktivität, sondern vor allem die Flexibilität erhöhen, bis hin zur kundenindividuellen Massenproduktion.

Die Fabrik 4.0 soll…

- sich selbst digital abbilden und simulieren können und gleichzeitig möglichst mit der Realität verschmelzen,

- Produktionssysteme, Produkte und Dienste mit Informationen ausstatten und miteinander kommunizieren lassen,

- durch Datenanalysen in ihrer Situation aufgenommen, überwacht und im Generellen optimiert werden,

- sich darauf aufbauend durch künstliche Intelligenz selbst steuern und im Speziellen auch selbst optimieren können.

Industrie 4.0 – Die Story

Industrie 4.0 ist ein Zukunftsprojekt der deutschen Bundesregierung und gilt als eine große Hoffnung für den Wirtschaft- und Technologiestandort Deutschland. Unterstützt wird die Koordination der Entwicklung von Technologien der Industrie 4.0 durch die drei großen deutschen Branchenorganisationen Bitkom (IT), ZVEI (Elektrontechnik) und VDMA (Maschinenbau). Die Unterstützung erfolgt z. B. durch Ausarbeitung von Standards für Schnittstellen, das Vertretens von Themen der Industrie 4.0 in der Öffentlichkeit und das Zusammenbringen der Industrieteilnehmer. Beim Thema Industrie 4.0 treffen sich Unternehmen aus den Branchen IT, Elektrotechnik und Maschinenbau bzw. Produktions-, Verfahrens- und Automatisierungstechnik.

Industrie 4.0 – Die Story der Industrialisierung

Die erste industrielle Revolution stand im Zeichen der Mechanik und begann ab Ende des 18. Jahrhunderts durch den Einsatz von mechanischen Arbeitsmaschinen sowie organisatorischer Konzepte wie die Arbeitsteilung und Arbeitsplanung. Die Industrie war geboren und sie wurde geprägt von Konzepten wie den Taylorismus und technische Errungenschaften wie Dampfmaschinen oder auch Spinnmaschinen. Diese Maschinen ermöglichten erste Ansätze der Automation. Baustellenfertigungen wandelten sich aus fabrikplanerischer Sicht der Fertigungsmittelanordnung teilweise in Werkstattfertigungen um. Dampfmaschinen unterstützten nicht nur die Produktion, sondern auch die Logistik. Lokomotive und Schiffe mit Dampfantrieben erhöhten die nationale Produktivität erheblich. Die wachsende Mechanisierung mit Fokus auf Produktivität schaffte jedoch eine wenig flexible Produktion. Diese Industrialisierung verschob viele Arbeitskräfte von Agrabetrieben in Fabriken.

Die zweite industrielle Revolution stand im Zeichen der elektrischen Energie begann Anfang der 20. Jahrhunderts und erhöhte die Produktivität erheblich. Produkte (z. B. Automobile) konnten zudem in verschiedenen Varianten hergestellt werden. Fließbänder erhöhten die Arbeitsproduktivität durch Beschleunigung und Standardisierung der innerbetrieblichen Logistik. Das Kernelement dieser Revolution war die elektrische Energie, die sich sehr viel genauer steuern lässt als Dampfmaschinen und Verbrennungsmotoren, so wurde die Reihen-/Linienfertigung möglich. Erste elektronische Schaltungen konnten zudem komplexere Arbeitsabläufe übernehmen, als nur rein mechanisch gesteuerte Maschinen.

Die dritte industrielle Revolution stand im Zeichen der Automatisierung und begann etwa Mitte der 1970er Jahre. Die Elektronik wurde leistungsfähiger und programmierbar, was sich nicht nur positiv auf die Produktivität auswirkte, sondern auch die Wandlungsfähigkeit und Flexibilität der Fabriken verbesserte. Geprägt durch Elektrotechnik und Informatik konnten Arbeitsabläufe nach einigen Jahren bis ins Detail geplant und gesteuert werden. Dieser Revolution wurden durch Fachrichtungen wie Messtechnik oder Automatisierungstechnik stark geprägt. Maschinenbau, Elektrotechnik und zunehmend auch die Informatik griffen ineinander und sorgten für extrem leistungsstarke Produktionsstätten. Viele Linienfertigungen konnten nahezu ganz ohne Unterstützung durch menschliche Arbeitskraft arbeiten. Maschinen der Robotik ersetzen viele Arbeitsschritte, die zuvor durch menschliche Handgriffe durchgeführt werden mussten. Die Revolution stand im Zeichen der Robotik, Standardisierung und der Fabrik-/Arbeitsplanung. Nicht nur die Produktion selbst gewann deutlich an Produktivität, sondern auch die Errichtung oder Anpassung von Produktionsstätten. Produkte oder gar ganze Fabriken konnten informationstechnisch simuliert und auf Datenträgern gespeichert werden.

Die vierte industrielle Revolution – die Industrie 4.0 – hat bereits in Ansätzen seit Beginn des 21. Jahrhunderts begonnen, wird voraussichtlich jedoch erst in den nächsten zwei Jahrzehnten ihre volle Blüte erreichen. Diese vierte Revolution wird im Zeichen der Vernetzung, Datenanalyse, virtuellen Realität und künstlichen Intelligenz stehen. Die Industrie 4.0 unterscheidet sich von den ersten drei Revolutionen dadurch, dass diese nicht nur die Produktivität erhöht (dies tut sie in einigen Teilen sogar nur unwesentlich oder gar nicht), sondern dass sie Produktion und Logistik wandlungsfähiger, flexibler und transparenter gestaltet.

Steigende Anforderungen an ERP-Systeme

In diesem Gastartikel schreibt Sascha Hochweber über die neue Trends bei ERP-Systemen und gestiegene Anforderungen, die heute an ERP-Systeme gestellt werden.

Ein modernes ERP-System soll ein Unternehmen bei der Umsetzung von wichtigen Kernprozessen zum reibungslosen Betriebsablauf unterstützen. Darunter fallen Kernelemente wie zum Beispiel die Senkung der laufenden Betriebskosten, sowie die Bereitstellung und Implementierung von neuen Services und hinzugewonnenen Ressourcen. Was bisher die ERP Systeme der neuesten Generation in Anlehnung an die individuellen Bedürfnisse des jeweiligen Unternehmens problemlos bewerkstelligen konnten, muss nicht grundlegend, aber umfangreich an neue Gegebenheiten angepasst werden.

Angesichts der erst kürzlich überwundenen Wirtschaftskrise und neuen Herausforderungen auf den Märkten durch politische Entscheidung und wirtschaftliche Verlagerungen, sollen neue IT-Lösungen aus dem ERP-Umfeld die Optimierung von bestehenden und neuen Geschäftsprozessen ermöglichen. Insbesondere mittelständische Unternehmen setzen bei einem ERP System auf ein ausgereiftes und angepasstes Liquiditätsmanagement. Doch das Liquiditätsmanagement ist lediglich ein Aspekt bei einem ERP System, welches künftig noch stärker in den Mittelpunkt als Herzstück eines jeden Unternehmens rückt.

Der immer größer werdende Kostendruck bei Unternehmen jeder Größenordnung wächst, sodass das vorhandene ERP-System seitens der IT zunehmend schneller angepasst werden muss. Hierbei spielen Kriterien wie etwa die schnelle Anpassung der Preise an die aktuellen Gegebenheiten des Marktes, sowie eine sich stetig wandelnde strategische Ausrichtung des Unternehmens eine wichtige Rolle.

Ältere ERP-Systeme waren ausschließlich in unterstützender Funktion vorhanden und gaben eine Plattform her, welche die Visualisierung von Geschäftsprozessen zur späteren Entscheidungsfindung ermöglichte. Nach einstimmiger Meinung von Experten müssen die heutigen Systeme in Zukunft von einer eher passiven Haltung in eine aktive Rolle schlüpfen und bei Entscheidungen beratend unterstützen. Dieser Umstand stellt an moderne ERP-Systeme in Sachen individueller Konfigurationsmöglichkeiten und der damit einhergehenden Skalierbarkeit eine Fülle neuer Anforderungen dar. Die sich ständig wandelnden Anforderungen an moderne ERP-Systeme werden vor allem eine Belastungsprobe

für die ERP-Architekturen, wie die Computerwoche schreibt.

Cloud Computing

Cloud Computing ist ein modernes Konzept der Bereitstellung von Programmlogik, Netzwerk-, Rechen- und/oder Speicherkapazität über Dienste im Internet.

Cloud Computing ist ein Begriff aus dem angelsächsischem Sprachraum und ins Deutsche nur schwer zu übersetzen, die möglichweise verständlichste Übersetzung ist „Rechnerwolke“. Die Wolke als Symbol für das Internet unterstreicht die Unbestimmtheit des Internets als weltweites und unüberschaubar verzweigtes Netzwerk. In der Netzwerktechnik sind Wolken das Symbol für das Internet im Netzwerkplan.

Der Bundesverband Informationswirtschaft, Telekommunikation und neue Medien e.V. definiert Cloud Computing wie folgt:

Cloud Computing ist eine Form der bedarfsgerechten und flexiblen Nutzung von IT-Leistungen. Diese werden in Echtzeit als Service über das Internet bereitgestellt und nach Nutzung abgerechnet. Damit ermöglicht Cloud Computing den Nutzern eine Umverteilung von Investitions- zu Betriebsaufwand. Die IT-Leistungen können sich auf:

- Anwendungen,

- Plattformen für Anwendungsentwicklungen und -betrieb und auf die

- Basisinfrastruktur

beziehen.

Von Diensten des Cloud Computing wird auch von Cloud-Diensten oder von Diensten in der Cloud gesprochen.